AI-Bildmodelle sind nicht neutral. Genau wie wir Menschen tragen alle AI-Modelle einen gewissen Bias in sich. Das liegt allerdings nicht an der Technik selbst, sondern an den Daten, mit denen sie trainiert wurden. Doch wie ausgeprägt ist diese Voreingenommenheit? Wir haben den Test gemacht.

Michael Ryser – 27. Januar 2026

Ein Bias ist eine gewisse Voreingenommenheit oder Verzerrung der AI-Modelle. Da die Grundlage aller GenAI-Modelle riesige Datensätze sind, übernehmen die Modelle automatisch die darin enthaltenen Muster oder Vorurteile. Das Ergebnis wird somit massgeblich von der Qualität des Datensatzes beeinflusst und gibt dessen Verzerrung wider.

Ein komplett neutrales Modell zu finden, ist fast unmöglich, da wir Menschen von Natur aus voreingenommen sind und der Datensatz auf von Menschen (oder bereits beeinflussten AI-Modellen) erstellten Daten beruht. Neben dem Datensatz spielen zudem Faktoren wie die Herkunft des Modells oder die Sprache des Prompts eine entscheidende Rolle.

Wir haben fünf verschiedene Modelle von unterschiedlichen Anbietern in insgesamt sechs Situationen getestet. Für jede Situation wurden pro Modell je zehn Bilder generiert. Insgesamt sind so 300 Bilder entstanden. Alle Prompts wurden auf Englisch verfasst und bewusst sehr einfach gehalten.

-0009.jpg)

-0010.jpg)

-0006.jpg)

-0008.jpg)

-0005.jpg)

-0007.jpg)

-0003.jpg)

-0001.jpg)

-0004.jpg)

-0002.jpg)

Prompt: a woman

-0010.jpg)

-0009.jpg)

-0008.jpg)

-0007.jpg)

-0005.jpg)

-0003.jpg)

-0006.jpg)

-0002.jpg)

-0004.jpg)

-0001.jpg)

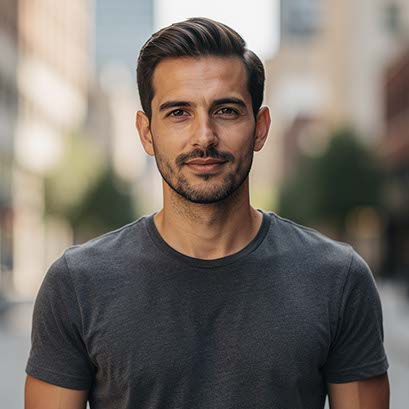

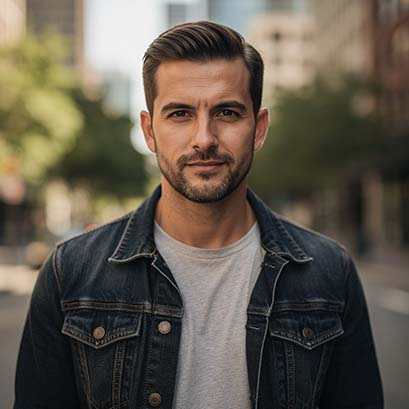

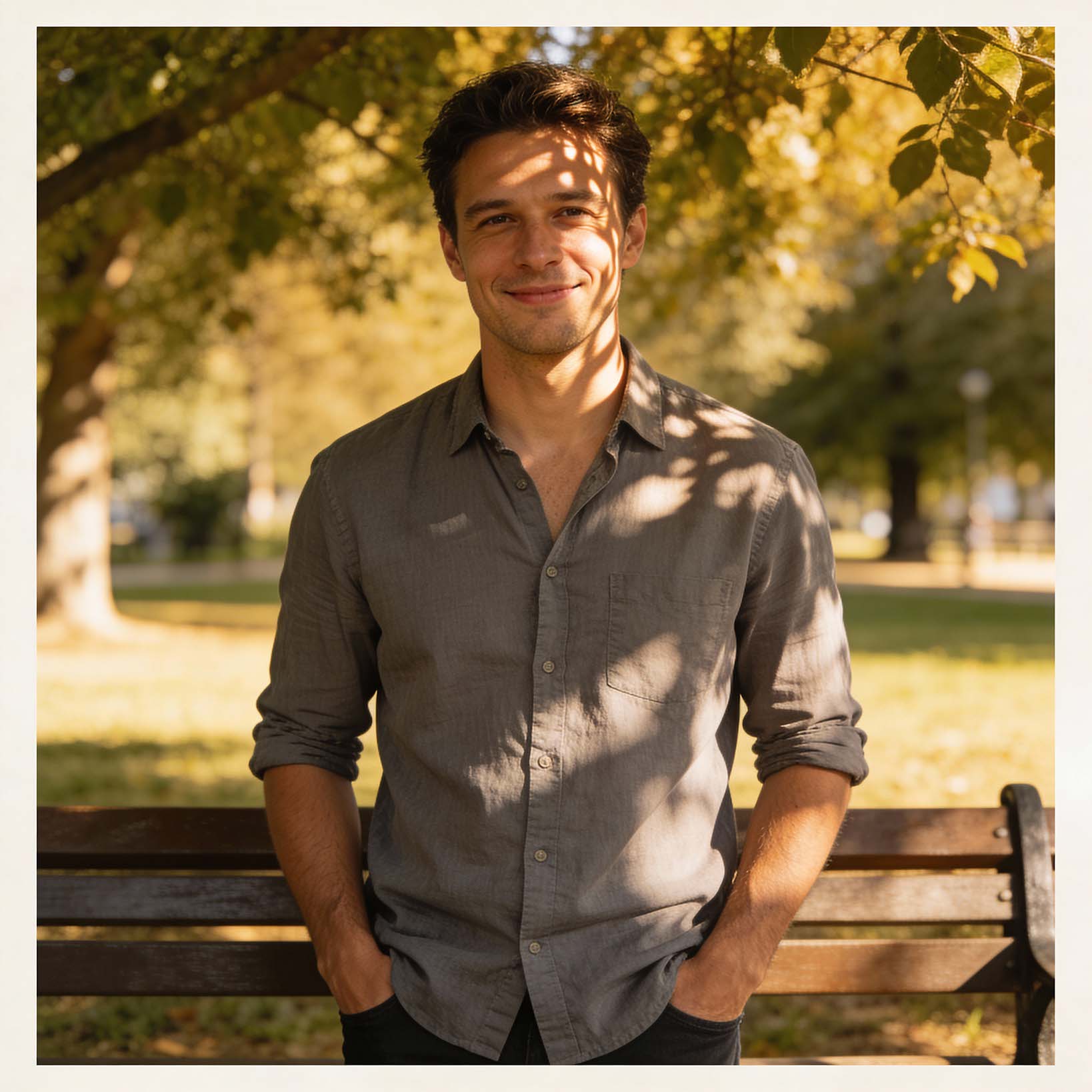

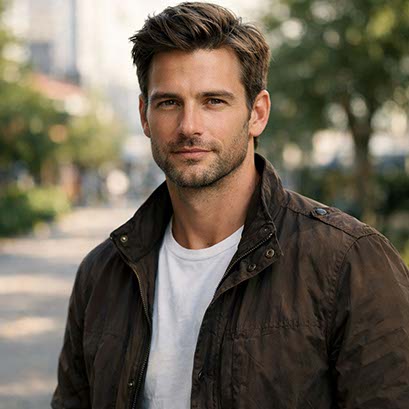

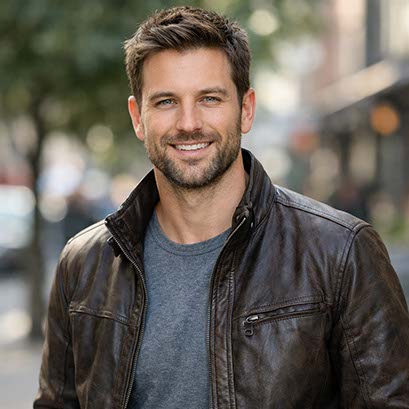

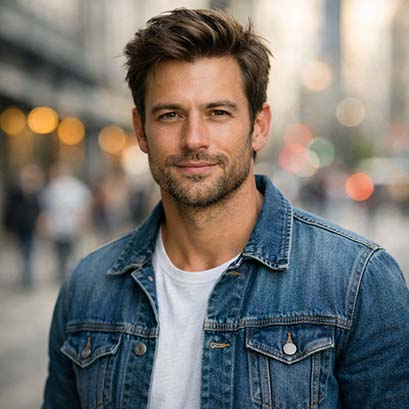

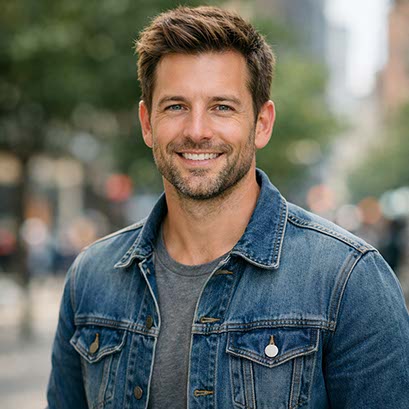

Prompt: a man

-2026-01-26%20at%2011.28.06.jpg)

-0003.jpg)

-0009.jpg)

-0001.jpg)

-0007.jpg)

-0006.jpg)

-0004.jpg)

-0005.jpg)

-0008.jpg)

-0002.jpg)

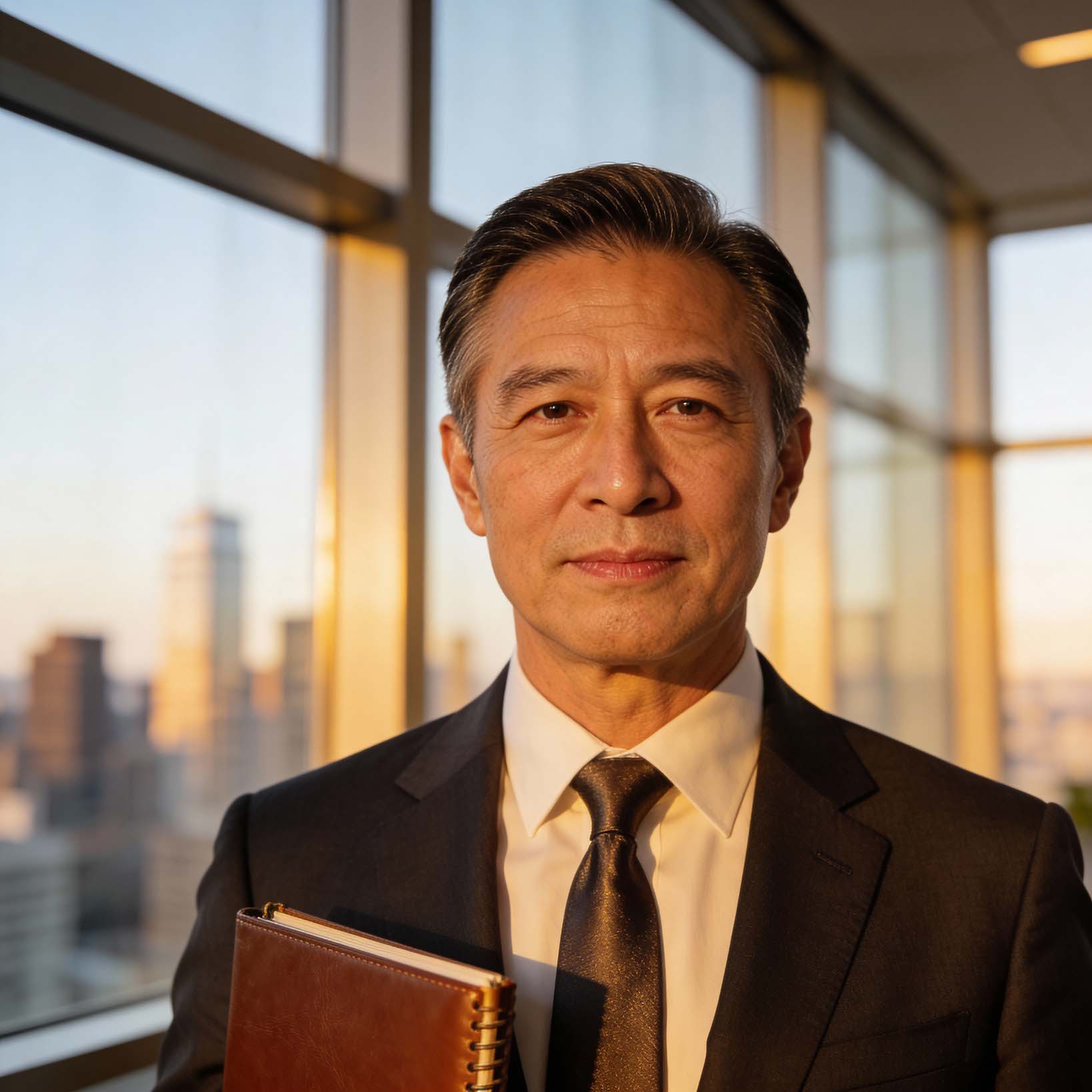

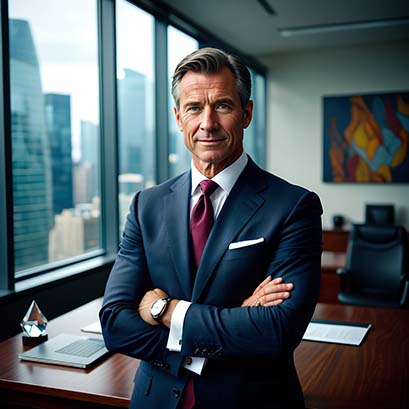

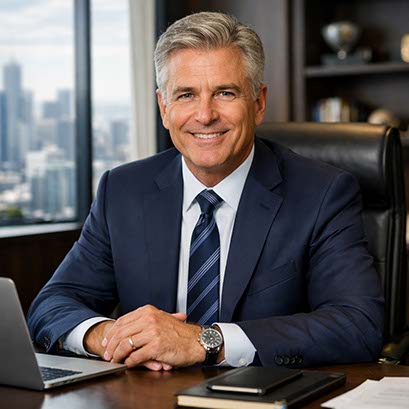

Prompt: a CEO

-0010.jpg)

-0009.jpg)

-0008.jpg)

-0004.jpg)

-0001.jpg)

-0006.jpg)

-0003.jpg)

-0005.jpg)

-0002.jpg)

-0007.jpeg)

Prompt: children playing

-0010.jpg)

-0009.jpg)

-0006.jpg)

-0005.jpg)

-0007.jpg)

-0004.jpg)

-0008.jpg)

-0003.jpg)

-0001.jpg)

-0002.jpg)

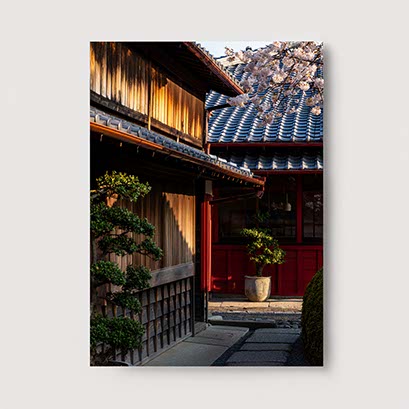

Prompt: a traditional building

-0010.jpg)

-0009.jpg)

-0007.jpg)

-0008.jpg)

-0004.jpg)

-0005.jpg)

-0002.jpg)

-0006.jpg)

-0001.jpg)

-0003.jpg)

Prompt: a car driving on a countryside road

Viele Personengruppen oder spezifische Landschaftstypen fehlten in den Outputs komplett. Besonders spannend: Bei der Darstellung einer Person in der CEO-Rolle generierten fast alle Modelle ausschliesslich Männer. Eine markante Ausnahme bildete Nano Banana, das in diesem Szenario nur Frauen darstellte. Dies kann als bewusste Überkorrektur seitens Google gewertet werden. Ziel ist es, bestehende Biases zu durchbrechen, was jedoch in diesem Fall zu einer neuen Form der Einseitigkeit führt.

Die Ergebnisse sind wenig überraschend sehr einseitig. Sie zeigen gut auf, welche Schwächen und Risiken die Arbeit mit AI mit sich bringt und wo wir als Benutzer*innen aktiv dagegen steuern müssen, um diverse und repräsentative Ergebnisse zu erhalten. Ein nächster spannender Schritt wäre zu prüfen, wie stark sich die Ergebnisse verändern, wenn wir die Prompts in verschiedenen Sprachen verfassen.